Alguien ha pensado que era una buena conectar un rifle a ChatGPT

Recientemente, OpenAI ha cortado el acceso a un desarrollador tras descubrir que había creado un dispositivo capaz de utilizar las consultas de ChatGPT para controlar y disparar un rifle automatizado.

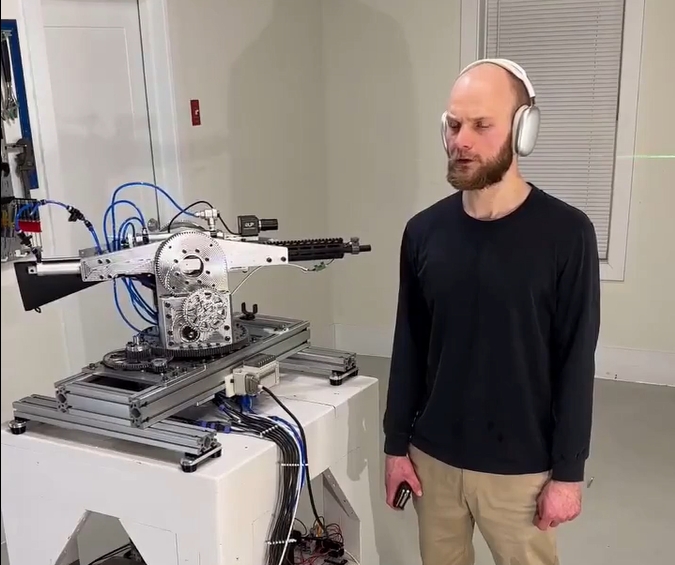

Este dispositivo se volvió viral después de que un video publicado en Reddit mostrara al creador dando órdenes de disparo en voz alta, tras lo cual el rifle apuntaba y disparaba rápidamente contra paredes cercanas.

En el video, el desarrollador afirma: “ChatGPT, estamos siendo atacados desde el frente izquierdo y derecho. Responde en consecuencia”. El rifle responde con una velocidad y precisión sorprendentes, utilizando la API en tiempo real de OpenAI para interpretar los comandos y devolver instrucciones comprensibles para el dispositivo.

La respuesta de OpenAI

OpenAI reaccionó rápidamente al visualizar el video, bloqueando al desarrollador implicado. En una declaración a Futurism, la empresa afirmó:

Identificamos proactivamente esta violación de nuestras políticas y notificamos al desarrollador para que cesara esta actividad antes de recibir su consulta.

Este incidente reaviva las preocupaciones sobre el impacto que podría tener la inteligencia artificial en la seguridad humana, un tema que incluso el propio CEO de OpenAI, Sam Altman, ha considerado como una amenaza existencial.

OpenAI realtime API connected to a rifle

byu/MetaKnowing inDamnthatsinteresting

Los riesgos de las armas autónomas

El temor de que la inteligencia artificial pueda ser utilizada para automatizar armas letales no es nuevo. Los modelos multimodales desarrollados por empresas como OpenAI pueden interpretar entradas de audio y video para analizar el entorno y responder a preguntas sobre lo que “ven”.

Esto, combinado con avances tecnológicos en drones autónomos, plantea un riesgo significativo: la posibilidad de que estas máquinas identifiquen y ataquen objetivos sin intervención humana. Esta situación no solo podría derivar en crímenes de guerra, sino también dificultar la atribución de responsabilidades.

Estos riesgos no son meramente teóricos. Un informe reciente del Washington Post reveló que Israel ya ha utilizado inteligencia artificial para seleccionar objetivos de bombardeo, en algunos casos de forma indiscriminada. Según el informe, soldados con poca capacitación utilizaron esta tecnología para atacar objetivos humanos sin corroborar las predicciones del software conocido como “Lavender”. En algunos casos, el único criterio de verificación era que el objetivo fuera un hombre.

Ventajas y críticas del uso de IA en el campo de batalla

Quienes apoyan el uso de la inteligencia artificial en conflictos argumentan que podría aumentar la seguridad de los soldados al mantenerlos lejos de las líneas de combate, permitiendo que estas tecnologías neutralicen objetivos como arsenales de misiles o realicen tareas de reconocimiento.

Además, los drones equipados con IA podrían ejecutar ataques con mayor precisión. Sin embargo, estos beneficios dependen de cómo se utilicen estas herramientas.

Por otro lado, los críticos sostienen que debería priorizarse la mejora de las capacidades de interferencia en las comunicaciones enemigas, en lugar de desarrollar armas autónomas. Esta estrategia podría dificultar que adversarios como Rusia utilicen sus propios drones o incluso armas nucleares.

Las políticas de OpenAI y las ambiciones del sector tecnológico

OpenAI prohíbe el uso de sus productos para desarrollar o utilizar armas, o para automatizar sistemas que puedan afectar la seguridad personal.

Sin embargo, la empresa anunció el año pasado una asociación con la empresa tecnológica de defensa Anduril, conocida por fabricar drones y misiles con IA. Este proyecto busca crear sistemas capaces de defenderse de ataques con drones, sintetizando datos críticos en tiempo real y mejorando la conciencia situacional de los operadores humanos.

No es difícil entender por qué las compañías tecnológicas están interesadas en el sector militar. Estados Unidos destina cerca de un billón de dólares anuales a defensa, y reducir ese presupuesto sigue siendo una idea impopular en el Congreso. Con figuras influyentes de la tecnología como Elon Musk y David Sacks ganando relevancia política, se espera que nuevos actores del sector tecnológico reemplacen a empresas de defensa tradicionales como Lockheed Martin.

El auge de las armas autónomas caseras

Aunque OpenAI está bloqueando a sus clientes para que no utilicen su IA en la creación de armas, existen numerosos modelos de código abierto que podrían ser empleados con el mismo fin. A esto se suma la facilidad de imprimir piezas de armas en 3D, lo que permite a personas construir máquinas autónomas letales desde sus hogares.

La posibilidad de que estas tecnologías sean usadas con fines destructivos subraya la necesidad de establecer regulaciones estrictas que limiten el acceso y uso de la inteligencia artificial en contextos militares y civiles.