🎁 ¡Nuevos cupones AliExpress! Códigoshasta 70€ válidos del 17/3 al 26/3 🎁

OpenAI ha dado hoy a conocer GPT-4, su mayor y más completo modelo de IA hasta la fecha, en su blog de investigación.

GPT-4 amplía las capacidades del último gran modelo lingüístico de OpenAI, GPT-3.5, con el que funciona el popular chatbot ChatGPT.

En particular, GPT-4 es multimodal, lo que significa que puede «ver», aceptando por primera vez tanto imágenes como texto. El sistema genera texto como salida.

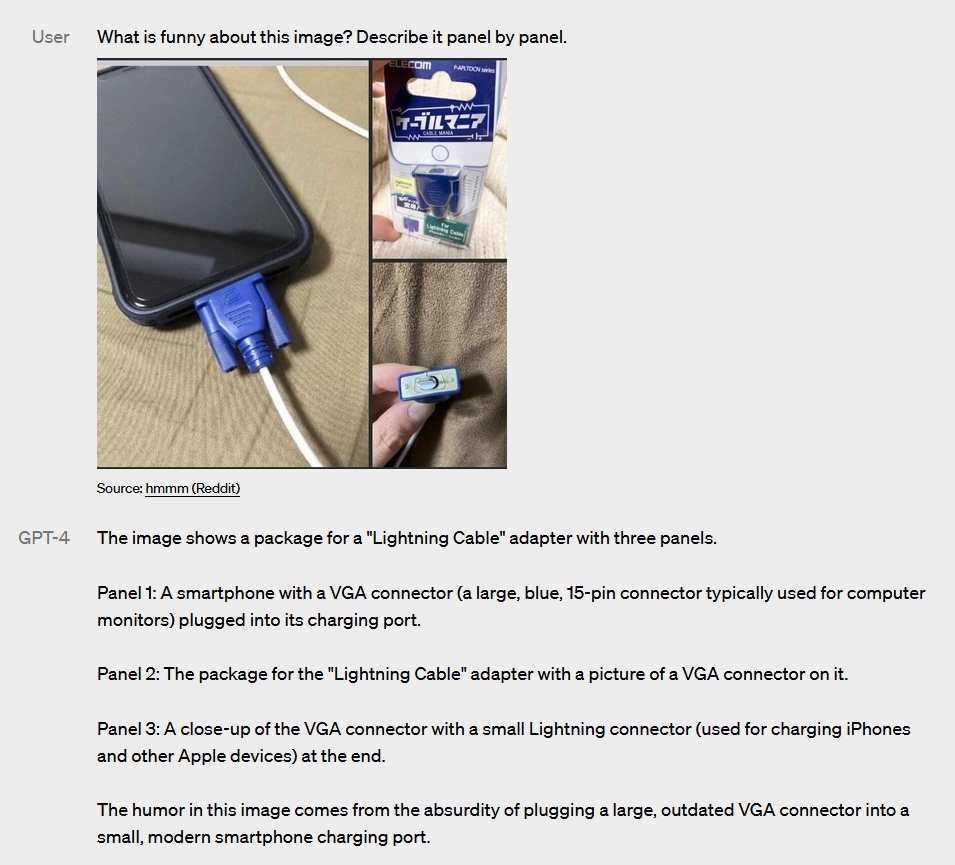

En el blog, OpenAI muestra una imagen junto con la pregunta «¿Qué hace a esta imagen graciosa? Descríbelo panel a panel»

Ejemplo de GPT-4

Para los usuarios ocasionales de ChatGPT, las mejoras de GPT-4 pueden resultar imperceptible. Pero en las pruebas de razonamiento, GPT-4 mejora a su predecesor de forma significativa.

Históricamente, los sistemas de IA han tenido problemas con el razonamiento, que requiere conocimientos de sentido común y del mundo físico.

GPT-4 sigue siendo una tecnología imperfecta, sobre todo en las áreas que han suscitado críticas. Según OpenAI, el sistema tiene un 40% más de probabilidades de responder con la verdad, lo que supone una mejora, pero gradual.

Por otra parte, los esfuerzos para alinear mejor el rendimiento de seguridad de GPT-4 con los valores humanos han dado como resultado un sistema que tiene un 82% menos de probabilidades de proporcionar contenido que viole las políticas de OpenAI, afirma la startup.

GPT-4 estará disponible en ChatGPT Plus, la versión premium de ChatGPT, y a través de API.