El CEO de Nvidia afirma que sus chips de IA evolucionan más rápido que la Ley de Moore

La innovación en el mundo de la tecnología no se detiene, y Nvidia parece estar liderando el camino.

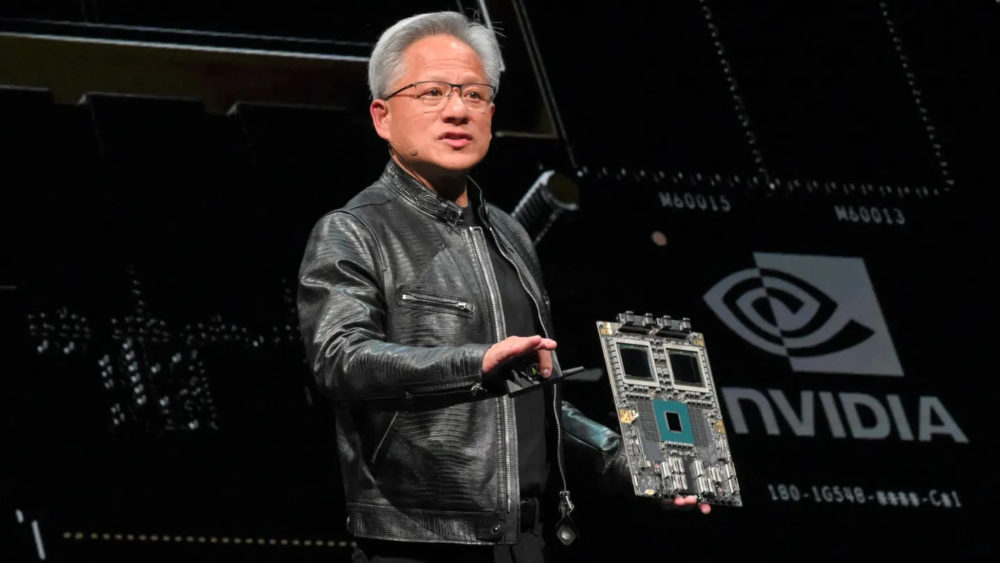

Según su CEO, Jensen Huang, los chips de inteligencia artificial (IA) de la compañía están avanzando a un ritmo que supera los estándares establecidos por la famosa Ley de Moore, un principio que guió el progreso en la computación durante décadas.

¿Qué es la Ley de Moore?

La Ley de Moore fue propuesta por Gordon Moore, cofundador de Intel, en 1965. Establecía que el número de transistores en un chip de computadora se duplicaría aproximadamente cada año, lo que también duplicaría su rendimiento.

Este principio impulsó grandes avances en la tecnología a lo largo de décadas, haciendo los dispositivos más potentes y accesibles. Sin embargo, en los últimos años, esta tendencia ha mostrado signos de desaceleración.

Nvidia: Innovando más allá del estándar

Jensen Huang asegura que Nvidia no solo está manteniendo el ritmo, sino superándolo. En una reciente entrevista, Huang destacó que los sistemas de Nvidia avanzan «mucho más rápido que la Ley de Moore». Un ejemplo de ello es el GB200 NVL72, su último superchip para centros de datos, que es entre 30 y 40 veces más rápido en tareas de inferencia de IA que su predecesor, el H100.

Según Huang, este progreso no se debe únicamente al desarrollo de chips más potentes, sino a la capacidad de Nvidia para innovar en toda la «pila tecnológica», incluyendo la arquitectura, los sistemas, las bibliotecas y los algoritmos.

Respondiendo a las dudas sobre el futuro de la IA

En un momento en que algunos expertos cuestionan si los avances en IA se están ralentizando, Huang rechaza esa idea. Según él, hay tres «leyes de escalado de IA» que están impulsando el progreso:

- Pre-entrenamiento: El proceso inicial donde los modelos aprenden patrones a partir de grandes cantidades de datos.

-

Post-entrenamiento: Ajustes específicos utilizando métodos como la retroalimentación humana.

-

Computación en tiempo de inferencia: La capacidad de un modelo de tomar más tiempo para «razonar» al responder preguntas.

Huang subraya que la computación en tiempo de inferencia es crucial, y que el rendimiento mejorado de los chips reducirá los costos de estas tareas, haciendo que la IA sea más accesible.

Desafíos de la inferencia y el camino hacia adelante

Aunque los modelos de IA que utilizan computación en tiempo de inferencia son costosos de operar hoy en día, Nvidia confía en que su tecnología ayudará a reducir significativamente estos costos. Un ejemplo notable es el modelo o3 de OpenAI, cuyo alto costo operativo ha generado preocupaciones. Huang asegura que con chips más avanzados, estos costos disminuirán con el tiempo, permitiendo que más personas y empresas adopten esta tecnología.

Más allá de los límites conocidos

El progreso de Nvidia no solo es notable por su velocidad, sino por su alcance. Según Huang, los chips de la compañía han mejorado 1,000 veces en los últimos 10 años, un ritmo que supera ampliamente los estándares establecidos por la Ley de Moore. Esta trayectoria sugiere que Nvidia seguirá desempeñando un papel clave en la evolución de la IA, impactando tanto en la industria como en nuestra vida cotidiana.

Con su capacidad para innovar en múltiples niveles y un enfoque claro en el rendimiento y la accesibilidad, Nvidia está redefiniendo lo que es posible en el mundo de la tecnología. Según Huang, «aún estamos en los comienzos de lo que la IA puede lograr».