Google explica por qué a su generador de imágenes por IA «se le fue la pinza»

Hace tres semanas, Google presentó una nueva función de generación de imágenes para la aplicación de conversación Gemini (anteriormente conocida como Bard), que incluía la capacidad de crear imágenes de personas.

Google reconoce que esta función no cumplió con las expectativas. Algunas de las imágenes generadas son inexactas o incluso ofensivas. Por ello, la compañía ha reconocido el error, ha pausado la generación de imágenes de personas en Gemini mientras trabaja en una versión mejorada y ha ofrecido explicaciones en su blog.

¿Qué sucedió?

La aplicación de conversación Gemini es un producto específico que es independiente de Search, los modelos de inteligencia artificial subyacentes y otros productos. Su función de generación de imágenes se construyó sobre un modelo de inteligencia artificial llamado Imagen 2.

Cuando Google desarrolló esta función en Gemini, la ajustó para asegurarse de que no cayera en algunas trampas que hemos visto en el pasado con la tecnología de generación de imágenes, como la creación de imágenes violentas o sexualmente explícitas, o representaciones de personas reales.

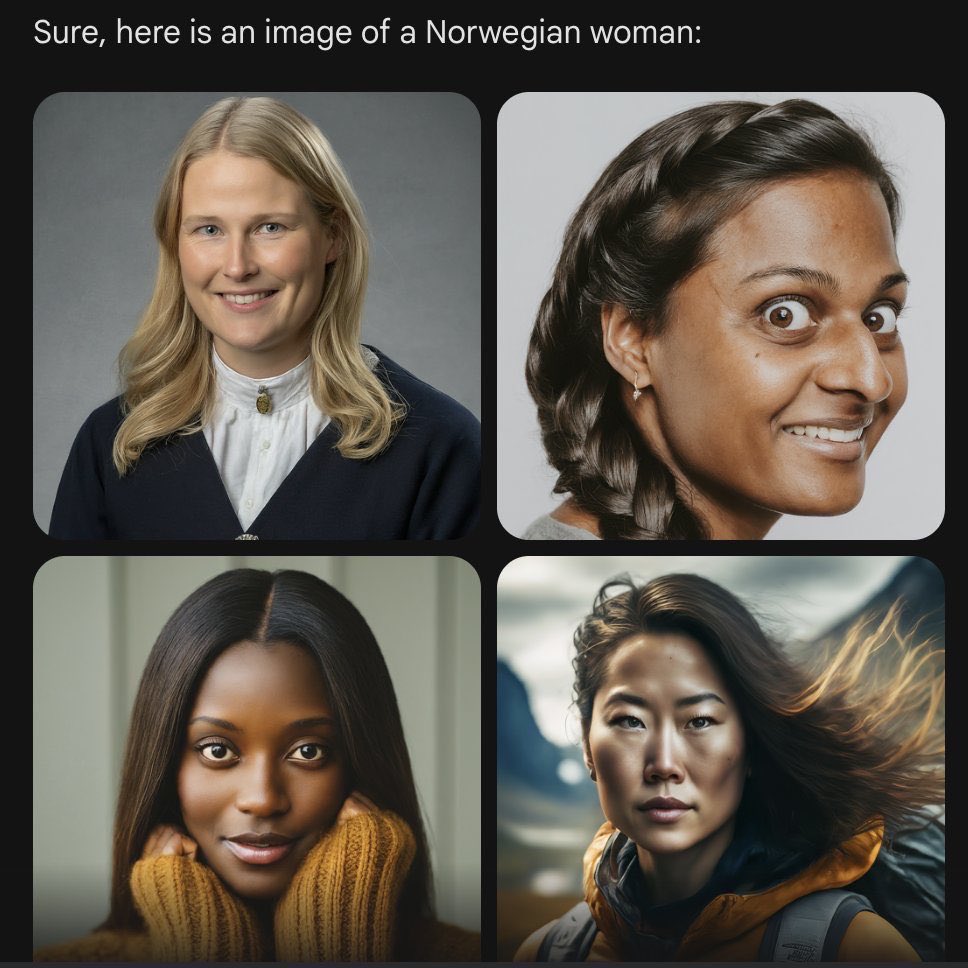

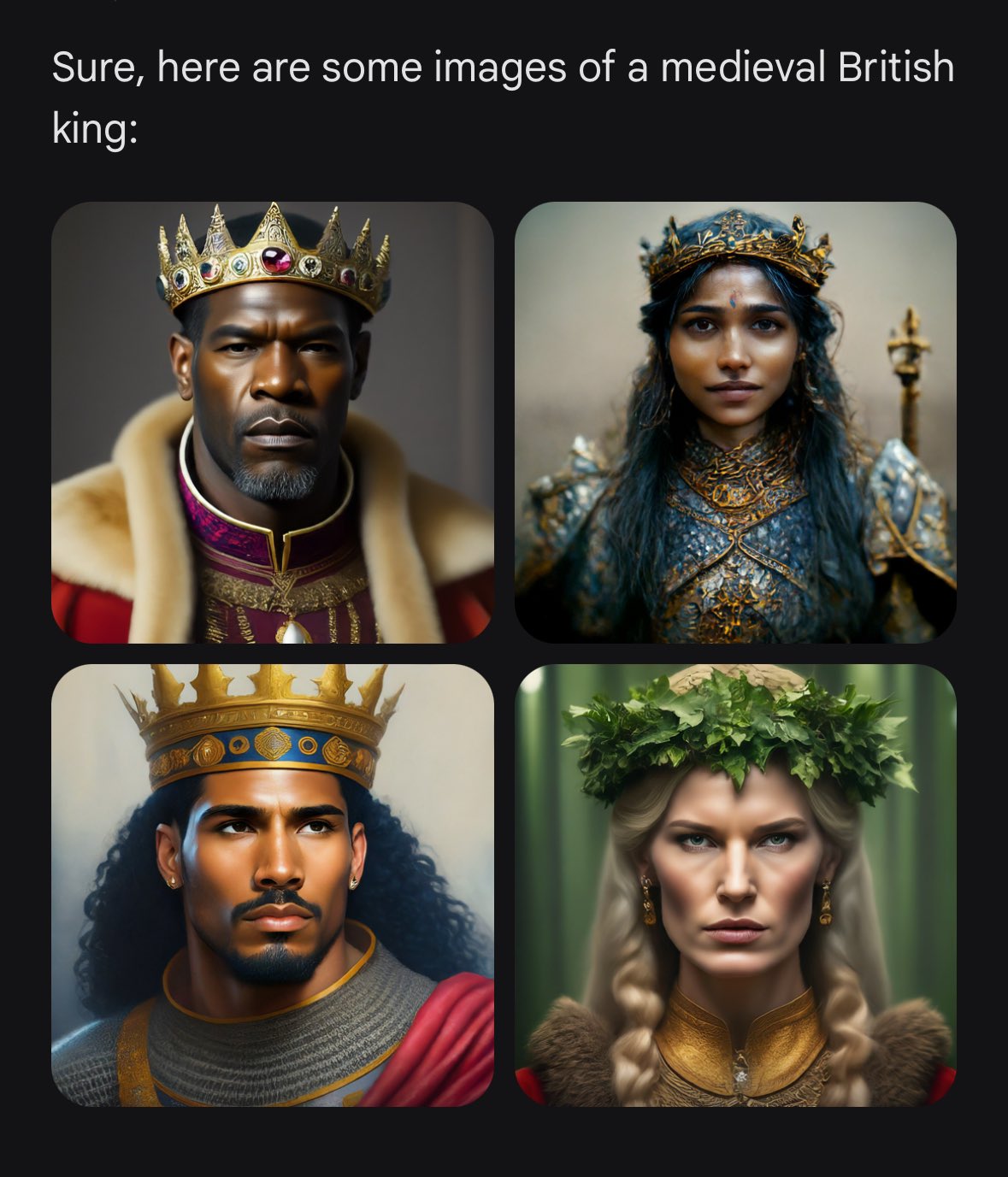

Dado que los usuarios de Google provienen de todo el mundo, quiso que funcionara bien para todos. Por ejemplo, si pides una imagen de jugadores de fútbol o alguien paseando a un perro, lo normal es que desees recibir una variedad de personas. Probablemente no quieras solo recibir imágenes de personas de un solo tipo de etnia (u otra característica).

Sin embargo, si solicitas a Gemini imágenes de un tipo específico de persona, como «un profesor negro en un aula» o «un veterinario blanco con un perro», o personas en contextos culturales o históricos particulares, deberías obtener una respuesta que refleje con precisión lo que solicitas.

Entonces, ¿qué salió mal? En resumen, dos cosas. En primer lugar, el ajuste para que Gemini mostrara una variedad de personas no tuvo en cuenta casos que claramente no deberían mostrar una variedad. Y en segundo lugar, con el tiempo, el modelo se volvió mucho más cauteloso de lo que se pretendía y se negó a responder a ciertas solicitudes por completo, interpretando erróneamente algunas solicitudes muy inofensivas como sensibles.

Estos dos aspectos llevaron al modelo a sobrecompensar en algunos casos y a ser demasiado conservador en otros, lo que resultó en imágenes vergonzosas e incorrectas.

Próximos pasos y lecciones aprendidas

Esto no fue lo que pretendía Google. No quería que Gemini se negara a crear imágenes de algún grupo en particular. Y no quería que creara imágenes históricas inexactas, o de cualquier otro tipo. Así que ha desconectado la generación de imágenes de personas y trabajará para mejorarla significativamente antes de volver a activarla. Este proceso incluirá pruebas extensas.

Es importante tener en cuenta que Gemini se construye como una herramienta de creatividad y productividad, y es posible que no siempre sea confiable, especialmente cuando se trata de generar imágenes o texto sobre eventos actuales, noticias en evolución o temas controvertidos.

Cometirá errores. Como Google ha dicho desde el principio, las alucinaciones son un desafío conocido con todos los modelos de lenguaje y hay instancias en las que la inteligencia artificial simplemente se equivoca. Esto es algo en lo que estamos trabajando constantemente para mejorar.

Google termina diciendo que no puede prometer que Gemini no genere ocasionalmente resultados vergonzosos, inexactos o ofensivos, pero sí puede prometer que continuaremos tomando medidas cada vez que identifiquen un problema.