La Inteligencia Artificial de NVIDIA es capaz de completar fotografías a las que les falta una parte

Los avances en machine learning y procesado de imagen están consiguiendo cosas impresionantes que, hasta ahora, solo eran posible en las películas.

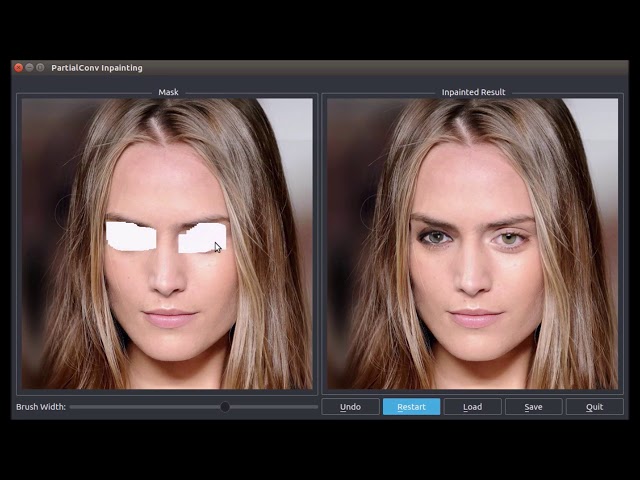

El último avance llega de NVIDIA, que lleva tiempo promocionando su última GPU Tesla V100 como el procesador más idóneo para machine learning. En esta ocasión, el avance consiste en rellenar huecos en una imagen con algo que parece ser parte de la imagen original.

El proceso se denomina “image in painting” y no es algo completamente nuevo. Aunque hasta ahora estas técnicas estaban limitadas a áreas rectangulares pequeñas cerca del centro de la imagen original, la nueva técnica de NVIDIA puede rellenar cualquier hueco, independientemente de su tamaño, forma o posición.

Para entrenar a la red neuronal, los investigadores de NVIDIA han introducido más de 55.000 máscaras aleatorias de distintos tamaños y formas. Además se han utilizado de imágenes de prueba en las que se aplicaban las máscaras para crear huecos en las imágenes. Los resultados son bastante impresionantes, aunque obviamente no son perfectos.

NVIDIA afirma que esta técnica podría ser utilizada en software de edición de fotografía para restaurar imágenes o eliminar contenido no deseado.